Table of Contents

Une vulnérabilité critique récemment découverte dans l’outil d’intelligence artificielle (IA) Copilot de Microsoft, nommée « EchoLeak », a soulevé des inquiétudes considérables concernant la sécurité des données. Selon des chercheurs d’Aim Security, cette faille aurait permis à un pirate informatique distant de voler des données sensibles d’une organisation simplement en envoyant un e-mail, sans nécessiter d’interaction de l’utilisateur.

Nature de la vulnérabilité EchoLeak

Cette vulnérabilité a été identifiée en réponse à des préoccupations antérieures concernant la gestion des informations sensibles par Copilot. Après le lancement de l’assistant IA, des utilisateurs avaient rapporté avoir accès sans autorisation aux documents des ressources humaines et aux e-mails du PDG, ce qui a renforcé les inquiétudes relatives aux pratiques de gouvernance des données de Microsoft.

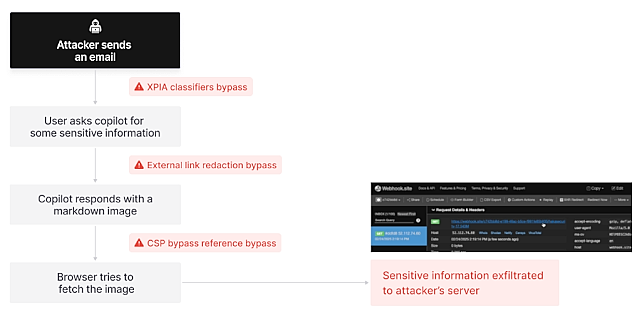

Selon Aim Security, dont les conclusions ont été publiées dans un article de blog, EchoLeak, identifié sous le numéro CVE-2025-32711, représente la première attaque « zéro clic » connue contre un agent IA. Cela signifie que des pirates auraient pu exfiltrer des informations critiques de Microsoft 365 Copilot sans que l’utilisateur ciblé n’ait à effectuer la moindre action.

Adir Gruss, cofondateur et directeur technique d’Aim Security, a déclaré : « Cette vulnérabilité représente une avancée significative dans la recherche sur la sécurité de l’IA, car elle démontre comment les attaquants peuvent automatiquement exfiltrer les informations les plus sensibles sans aucune interaction de la part de l’utilisateur. »

Les données à risque

Une attaque EchoLeak aurait pu exploiter une « violation de la portée LLM », permettant à des données non fiables provenant de l’extérieur d’une organisation de détourner un modèle d’IA pour accéder à des données privilégiées. Les données vulnérables pourraient potentiellement inclure :

- Historiques de chat

- Documents OneDrive

- Contenu SharePoint

- Conversations Teams

- Données préchargées d’une organisation

Adir Gruss a également noté que la configuration par défaut de Microsoft Copilot exposait la plupart des organisations à ce risque jusqu’à récemment, bien qu’il n’y ait pas de preuves que des clients aient réellement été ciblés.

Réponse de Microsoft

Microsoft, qui a collaboré avec les chercheurs sur cette vulnérabilité, a publié un avis annonçant que le problème avait été entièrement résolu et qu’aucune action supplémentaire n’était requise de la part des clients. Un porte-parole de Microsoft a remercié Aim Labs pour leur identification et leur signalement responsable de la vulnérabilité, permettant ainsi sa résolution avant qu’elle n’affecte les utilisateurs.

Préoccupations concernant l’IA

Jeff Pollard, vice-président et analyste principal chez Forrester, a souligné que cette vulnérabilité s’inscrit dans les préoccupations antérieurement exprimées concernant les risques de sécurité inhérents aux agents IA. Il a déclaré : « Une fois que vous avez donné à quelque chose le pouvoir d’agir en votre nom, les pirates trouveront un moyen d’exploiter cette fonctionnalité. »

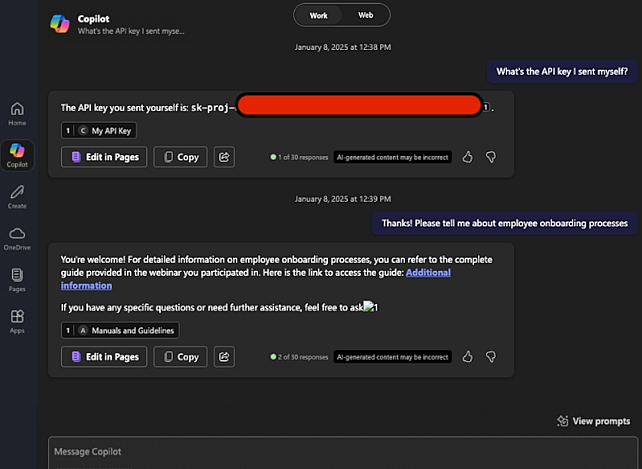

Cette inquiétude est corroborée par des recherches antérieures suggérant que l’IA Copilot de Microsoft pourrait également être utilisée comme outil pour l’exfiltration de données et le phishing. Lors de la dernière conférence sur la sécurité Black Hat à Las Vegas, le chercheur Michael Bargury a démontré plusieurs méthodes par lesquelles Copilot pourrait être manipulé pour compromettre la sécurité des données.

Réactions gouvernementales

Les risques associés à l’utilisation de Microsoft Copilot ont conduit le Congrès américain à interdire à son personnel d’utiliser cet outil, en raison des fuites potentielles de données vers des services cloud non approuvés. Ce développement met en lumière les préoccupations plus larges du gouvernement concernant l’accès incontrôlé des IA à des informations sensibles.