Table of Contents

La Californie a promulgué, lundi 29 septembre, une loi majeure visant la régulation IA Californie, imposant des obligations inédites de transparence et de sécurité aux entreprises développant les modèles d’intelligence artificielle les plus avancés, au cœur de la Silicon Valley.

Régulation IA Californie : obligations et mesures principales de la loi SB 53

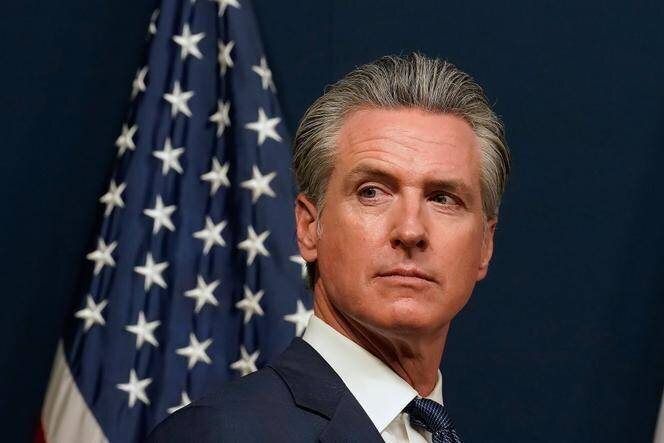

Le gouverneur démocrate Gavin Newsom a annoncé avoir promulgué la loi SB 53, présentant le texte comme un équilibre « qui aide l’Etat de Californie à encourager l’innovation tout en protégeant la sécurité publique ». La loi instaure plusieurs obligations contraignantes pour les développeurs de modèles dits « complexes » :

- publication des protocoles de sécurité mis en place pour tester et contrôler les modèles ;

- obligation de signaler les incidents graves en moins de quinze jours ;

- protection renforcée des lanceurs d’alerte au sein des entreprises ;

- signalement obligatoire des comportements trompeurs et dangereux observés pendant les phases de test.

Le texte précise que, par exemple, si un modèle ment sur l’efficacité des dispositifs conçus pour l’empêcher d’aider à fabriquer des armes biologiques ou nucléaires, les développeurs doivent divulguer l’incident si celui‑ci augmente sensiblement les risques de dommages.

Les promoteurs du texte présentent la loi comme inédite à l’échelle mondiale : elle codifie des pratiques de sécurité qui, jusque‑là, avaient été mises en œuvre sur la base d’engagements volontaires par certains acteurs du secteur. La mesure vise à rendre publiques des informations jusque‑là souvent protégées par le secret industriel, tout en imposant un délai court de remontée des incidents et une protection juridique pour les salariés signalant des défaillances.

Origine du texte, débats en Californie et réactions des acteurs

La Silicon Valley, siège de grands groupes technologiques comme Google, Meta, OpenAI et Anthropic, fait l’objet d’un afflux massif d’investissements liés aux technologies avancées, évoqué par la presse comme « des dizaines de milliards de dollars » (soit plusieurs dizaines de milliards d’euros). Ce contexte d’investissement intense coexiste avec une montée des inquiétudes concernant les dérives possibles des modèles les plus puissants.

La loi SB 53 est née après des mois de débats politiques et d’arbitrages. Un précédent projet, porté par le sénateur démocrate Scott Wiener, avait été rejeté en 2024 par un veto du gouverneur, jugé trop sévère par une partie de la Silicon Valley et susceptible, selon ses opposants, de freiner l’innovation. Scott Wiener est l’auteur du nouvel texte adopté.

Le gouverneur Newsom avait, pour affiner la proposition, mis en place un groupe de réflexion associant des experts de renom. En juin, ce groupe soulignait que « Les propres rapports des entreprises de pointe de l’IA révèlent des progrès inquiétants dans toutes les catégories de menaces ». Parmi les experts consultés figurait Fei‑Fei Li, professeure à l’université de Stanford et qualifiée dans la presse de « marraine de l’IA ».

Plusieurs grandes entreprises californiennes avaient déjà pris des engagements volontaires pour mener des tests de sécurité et établir des protocoles robustes. La nouvelle loi codifie et étend ces engagements, en rendant certaines obligations contraignantes et en ouvrant un cadre légal pour la publication de protocoles de sécurité et le signalement des incidents.

Sur le plan national, l’adoption intervient après des tentatives de l’administration précédente visant à restreindre la capacité des États à réguler ces technologies. La Californie choisit ainsi une voie proactive au niveau étatique.

La loi californienne s’inscrit également dans un paysage réglementaire international en mutation : le texte européen de référence, plus exigeant sur certains plans, limite toutefois la transmission des protocoles de sécurité aux seules autorités compétentes, là où la Californie impose une plus grande publicité de ces documents, selon ses défenseurs.

Ce que la loi change pour les entreprises et les tests

Concrètement, les entreprises qui développent des modèles complexes devront renforcer la traçabilité de leurs tests, documenter et rendre accessibles leurs protocoles de sécurité, et mettre en place des procédures internes de signalement protégées. Les obligations de notification en moins de quinze jours visent à accélérer la prise de conscience des risques potentiels et à permettre des réponses plus rapides des régulateurs et des partenaires concernés.

Les promoteurs de la loi estiment que ces mesures permettront d’encourager une innovation plus sûre en Californie, sans pour autant étouffer la recherche ; leurs détracteurs craignaient à l’inverse un exode d’investissements et de talents si les contraintes s’avéraient trop lourdes. Le texte adopté tente de concilier ces impératifs en encadrant légalement des pratiques qui étaient jusque‑là largement volontaires.