Table of Contents

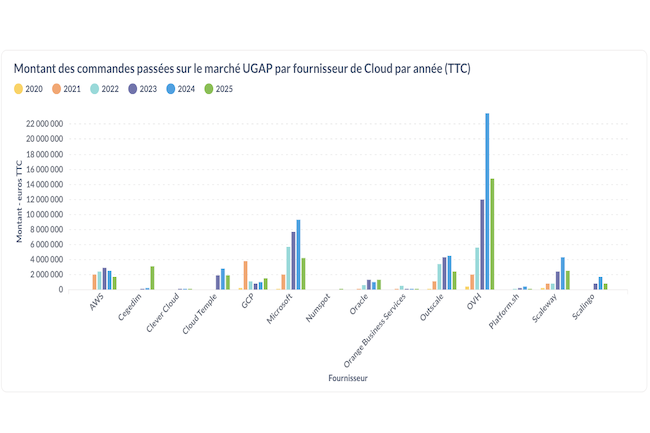

En 2024, les administrations françaises continuent de faire appel aux services cloud via l’UGAP, avec une nette domination d’OVH et d’Azure sur le marché des commandes publiques.

OVH et Azure en tête

Les commandes cloud passées par les administrations via l’UGAP ont principalement profité à OVHcloud, qui a enregistré 23,4 millions d’euros de commandes publiques. Microsoft Azure se classe en deuxième position avec 9,3 millions d’euros. Les autres fournisseurs notables incluent Outscale avec 4,4 millions d’euros, Scaleway avec 4,3 millions d’euros et AWS avec 2,5 millions d’euros. Cette diversité souligne l’importance des acteurs français dans la transformation numérique du secteur public.

Cependant, il est important de se demander si toutes les commandes publiques transitent effectivement par l’UGAP, car d’autres centrales d’achats telles que Resah et Uniha, principalement pour le secteur de la santé, existent également.

xAI et le lancement de Grok 4

Dans le domaine de l’intelligence artificielle, xAI, la société d’Elon Musk, a récemment lancé Grok 4, son dernier modèle d’IA, accompagné d’un abonnement à 300 € HT par mois, intitulé SuperGrok Heavy. Ce tarif est considéré comme élevé par rapport à ses concurrents tels que Perplexity Max à 200 € HT et Google AI Ultra à 275 € HT.

Selon les déclarations d’Elon Musk, « Grok 4 est meilleur que le niveau doctoral dans toutes les matières académiques, sans exception ». xAI prétend que ce modèle a montré des performances impressionnantes lors du test Humanity Last Exam, obtenant un score de 25,4 %, surpassant ainsi ses concurrents comme Gemini 2.5 Pro de Google et o3 d’OpenAI.

AWS et ses nouvelles instances GB200

Amazon Web Services (AWS) a également introduit de nouvelles instances EC2 GB200 NVL72, conçues pour la programmation et l’entraînement avancé de modèles d’intelligence artificielle. Ce système performant, qui comprend 36 processeurs Grace et 72 GPU Blackwell, utilise une connectivité NVLink-C2C pour une bande passante de 900 Go/s.

AWS affirme que ces instances permettent d’accélérer l’entraînement des modèles d’IA de nouvelle génération et d’améliorer les performances en temps réel de l’inférence dans les applications. Elles sont adaptées pour des usages variés, allant de la génération de contenu à l’intégration dans des applications d’IA générative.