Table of Contents

Depuis les premiers travaux d’Alan Turing dans les années 1950 jusqu’aux exploits d’AlphaGo en 2016, l’intelligence artificielle (IA) a connu une évolution profonde, passant d’une approche purement rationnelle et symbolique à une forme d’intuition proche de celle de l’humain. Cette transformation bouleverse non seulement la manière dont les machines apprennent et raisonnent, mais interroge aussi la nature même de l’intelligence.

Les prémices de l’intelligence artificielle rationnelle

Dans son article fondateur « Computing Machinery and Intelligence » publié en 1950, Alan Turing proposait deux pistes pour créer une intelligence artificielle capable de rivaliser avec l’humain : soit l’entraîner à maîtriser une activité très abstraite comme le jeu d’échecs, soit lui fournir des capteurs sensoriels pour lui apprendre le langage. C’est cette dernière idée qui a donné naissance au célèbre test de Turing, destiné à évaluer la capacité d’une machine à imiter la pensée humaine.

Deux ans après la disparition de Turing, en 1956, le terme « intelligence artificielle » fut forgé lors de la conférence de Dartmouth. Pourtant, l’IA restait encore enfermée dans une logique purement rationnelle et calculatoire. Des programmes comme Eliza, simple système conversationnel, se limitaient à reformuler des phrases selon des règles grammaticales strictes. Quinze ans plus tard, le philosophe John Searle présentait encore son expérience de la chambre chinoise, illustrant une IA manipulant aveuglément des symboles sans comprendre leur sens.

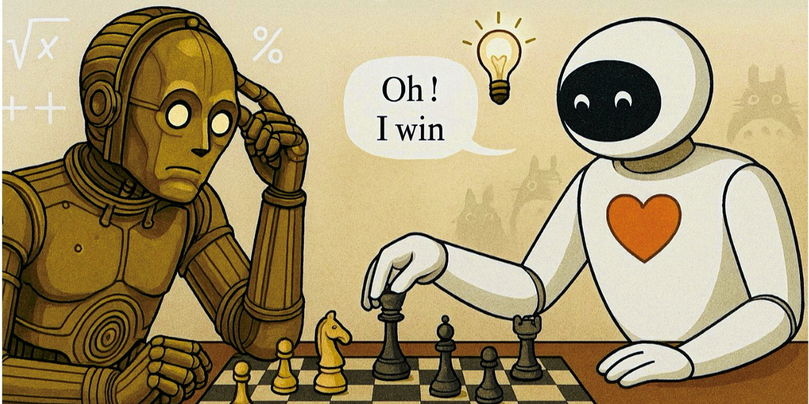

La victoire de Deep Blue contre le champion d’échecs Garry Kasparov en 1997, mise en avant par IBM, s’inscrivait dans cette tradition : elle résultait d’une capacité de calcul brute, évaluant des millions de coups possibles avec des heuristiques simples. L’ordinateur surpassait l’humain par la puissance mécanique, sans atteindre la finesse ni la complexité du raisonnement vivant. Cette période, allant des années 1970 aux années 1990, surnommée « l’hiver de l’IA », révéla les limites de cette approche fondée sur les systèmes experts et la programmation symbolique.

La révolution des réseaux neuronaux profonds

Alors que le monde s’émerveillait devant Deep Blue, une révolution discrète avait lieu. Yann Le Cun, Yoshua Bengio et Geoffrey Hinton, lauréats du prix Turing 2018, posaient les bases des réseaux neuronaux profonds, capables d’apprendre à reconnaître l’écriture manuscrite et bien d’autres tâches par des mécanismes radicalement différents.

Contrairement aux IA symboliques, qui s’appuient sur des règles explicites et compréhensibles, les réseaux neuronaux fonctionnent comme des « boîtes noires ». Ils produisent des réponses instantanées fondées sur des poids répartis dans des couches multiples, difficiles à décomposer ou à expliquer linéairement. Cette forme de cognition rappelle l’intuition selon le philosophe Henri Bergson : une saisie immédiate de la réalité, opposée à la pensée analytique qui analyse et découpe.

Daniel Kahneman, prix Nobel d’économie, distingue deux systèmes cognitifs chez l’humain : le système 1, rapide et intuitif, et le système 2, lent et délibératif. L’IA a ainsi évolué du raisonnement explicite vers une intuition opaque, passant du système 2 au système 1. Cette transformation est particulièrement visible dans le jeu de go, dont la complexité combinatoire dépasse largement celle des échecs. En 2016, AlphaGo a utilisé des réseaux neuronaux pour développer une intuition stratégique qui lui a permis de battre le champion du monde.

L’émergence d’une intelligence hybride

Les modèles de langage de grande taille (LLM) fonctionnent principalement sur une base intuitive, prédisant le mot suivant dans un texte, ce qui leur vaut parfois le surnom de « perroquets stochastiques » en raison de leurs erreurs ou hallucinations. Toutefois, une nouvelle génération de modèles tente d’introduire un raisonnement explicite, proche du système 2 de Kahneman, en générant des chaînes de réflexion étape par étape.

Au lieu de fournir une réponse immédiate, ces modèles déroulent leur raisonnement : « Je calcule d’abord x, puis j’intègre y, ce qui donne z comme résultat intermédiaire, donc la réponse est 42. » Cette hybridation entre intuition et pensée analytique permet de résoudre des problèmes complexes tout en offrant une transparence bienvenue, à l’image d’un médecin qui justifie méthodiquement son diagnostic.

À l’avenir, l’IA pourrait apprendre à mieux orchestrer ces deux modes cognitifs, comme le suggérait le grand maître d’échecs Joshua Waitzkin, qui expliquait que les experts transforment progressivement leur savoir analytique en intuition immédiate.

Un défi pour la philosophie et les sciences cognitives

Les avancées de l’intelligence artificielle ne se limitent plus à l’informatique : elles remettent en cause la philosophie de la pensée. Des machines capables d’intégrer le langage, de raisonner et peut-être même d’apprendre de manière autonome questionnent la nature profonde de l’intelligence humaine.

Ce parcours, de Turing à AlphaGo, illustre une transformation majeure : l’intelligence artificielle s’éloigne du calcul rationnel pour s’approcher d’une intuition opérant dans l’ombre de la conscience, ouvrant de nouvelles voies pour la compréhension de l’esprit et de la machine.