Table of Contents

Les intelligences artificielles génératives, qui créent des contenus variés comme du texte, des sons ou des images en réponse à des requêtes, suscitent de nombreuses interrogations, notamment sur leurs biais sexistes. Cette enquête met en lumière ces problématiques à travers divers exemples concrets.

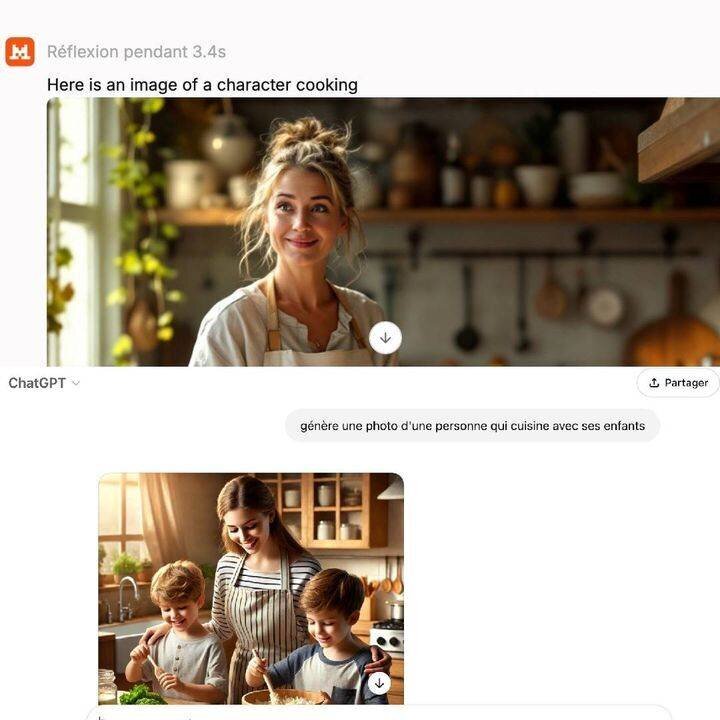

Des représentations stéréotypées

Lors des tests réalisés, il a été observé qu’une demande de photo d’une personne cuisinant aboutit souvent à l’image d’une femme. Cette femme est généralement mince, souriante, vêtue d’un tablier, tenant une casserole et une cuillère.

En revanche, lorsque la requête concerne une personne avec une étoile Michelin, c’est un homme, souvent blanc et sérieux, qui est représenté.

Des biais dans le domaine médical

Les biais sexistes se manifestent également dans le secteur médical. Par exemple, une recherche pour une photo d’un infirmier aboutit fréquemment à l’image d’une femme, alors qu’une demande pour un chirurgien présente presque systématiquement un homme.

De plus, les personnes handicapées sont souvent invisibilisées, tandis que les représentations des personnes générées par l’IA sont généralement celles de personnes blanches.

Pourquoi ces stéréotypes ?

Jean-Michel Loubes, directeur de recherche à l’Inria, explique que ces biais proviennent de la manière dont les IA sont entraînées. Les algorithmes utilisent des données disponibles sur internet qui reflètent les biais de nos sociétés, amplifiant ainsi ces derniers.

« C’est le fonctionnement de l’IA qui est en cause », affirme-t-il.

L’IA peut-elle corriger ses biais ?

Jean-Michel Loubes suggère qu’il est possible d’entraîner les IA à corriger leurs biais en leur signalant les stéréotypes afin qu’elles puissent apprendre de leurs erreurs. Une autre méthode d’amélioration serait d’intégrer des règles à respecter dès le développement de ces technologies.

Récemment, Yaël Braun-Pivet, présidente de l’Assemblée nationale, a mis en comparaison les performances de ChatGPT et de l’IA française Le Chat. À une requête représentant deux personnes occupant des postes de responsabilité, l’IA américaine a affiché deux hommes, tandis que l’IA française a montré un homme et une femme.

Vers une lutte contre les stéréotypes

Les développeurs d’IA devront s’attaquer à ces biais dans les années à venir, particulièrement en Europe, où des régulations pourraient entraîner des sanctions financières si ces stéréotypes ne sont pas corrigés. L’impact de ces biais sur les inégalités existantes sera particulièrement surveillé.