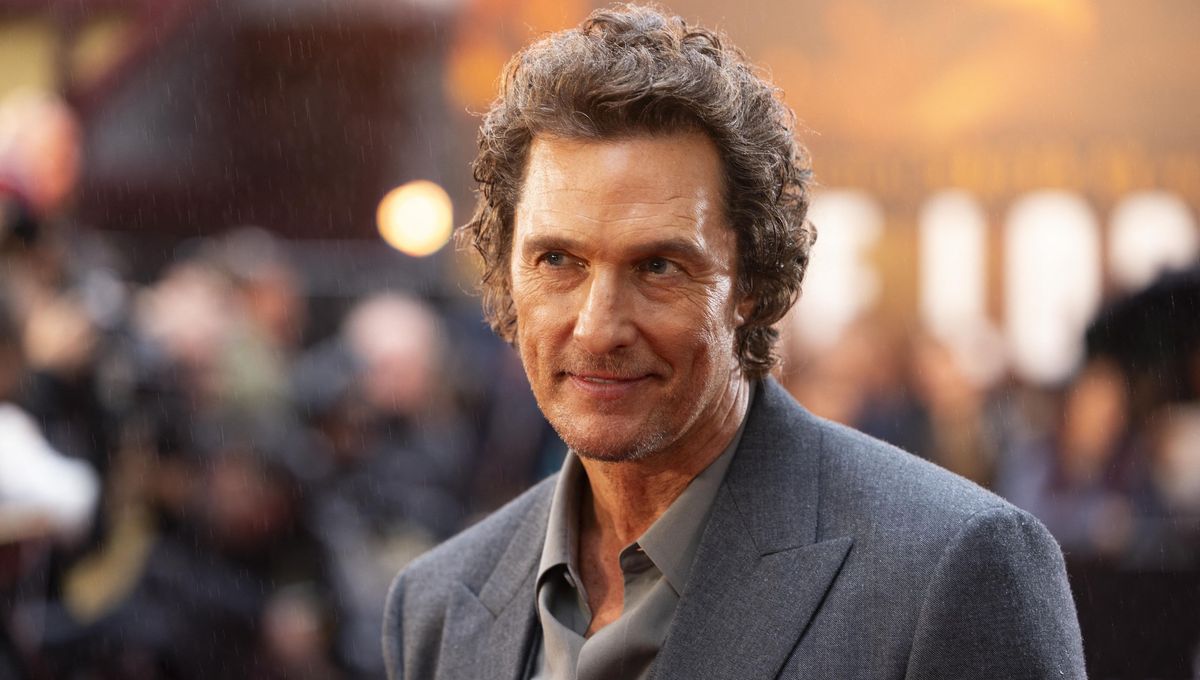

Les droits d’image et de voix à l’ère de l’intelligence artificielle deviennent un sujet sensible. Matthew McConaughey a pris une démarche audacieuse pour protéger son image et sa voix en déposant des extraits vidéo et sonores auprès de l’office américain des marques. Cette démarche vise à disposer d’une preuve officielle en cas d’utilisation non autorisée, notamment face aux deepfakes et aux montages générés par IA. En parallèle, l’acteur a investi dans la start-up Eleven Labs, une prise de position qui montre qu’il n’est pas opposé à l’IA, mais exige un consentement clair et rémunéré. Cette actualité illustre les tensions entre innovation technologique et droits individuels et pose la question de l’efficacité des garde-fous actuels.

Protection de l’image et de la voix par des dépôts juridiques

Le dispositif envisagé par des célébrités consiste à déposer des vidéos et extraits sonores pour établir la propriété intellectuelle de leur visage et de leur voix. En octobre 2025, l’image de Martin Luther King a été utilisée dans des vidéos générées par IA, avec des interdictions publiques de certaines utilisations, bien que les fichiers déjà créés continuent de circuler. Le cadre juridique reste complexe et évolutif.

Dans ce contexte, des plateformes promettent des garde-fous, comme des filigranes ou des métadonnées synchronisées, mais des outils permettent encore de contourner ces protections. Le débat porte sur l’équilibre entre innovation technologique et droits individuels et sur le rôle des législateurs et des entreprises dans le contrôle rapide des contenus générés.

Enjeux pour les plateformes et les normes à venir

Face à la vitesse de l’IA et à la popularité des réseaux, les acteurs évoquent des garde-fous et des normes renforcées, tout en reconnaissant des difficultés d’application. OpenAI et d’autres géants du secteur publient des mesures, mais les exemples récents montrent que les contenus générés continuent de circuler malgré les retraits. Le recours à des preuves juridiques et à des mécanismes techniques devient une composante clé de la protection des personnalités publiques.

Le cas Thibo InShape illustre aussi les limites des outils actuels: une vidéo où l’influenceur a été pris dans des montages choquants a démontré que les contenus rebondissent une fois retirés. Avec des revendications accrues sur les droits, les plateformes sont poussées à accélérer les procédures et à clarifier les règles entourant l’utilisation des voix et des visages virtuels.