Table of Contents

Dans un contexte de solitude croissante et de difficultés dans le secteur des soins de santé mentale, les gens se tournent de plus en plus vers les chatbots d’IA pour divers besoins, allant de l’accompagnement professionnel à la romance. La dernière étude d’Anthropic révèle que son chatbot, Claude, réussit sur ces terrains, mais suscite des réserves chez certains experts.

Une étude sur les capacités émotionnelles de Claude

Jeudi dernier, Anthropic a publié une étude sur les capacités d’intelligence émotionnelle (QE) de son chatbot Claude, désignée comme l’utilisation affective des chatbots. Selon l’entreprise, « les gens s’engagent directement avec Claude dans des échanges dynamiques et personnels motivés par des besoins émotionnels ou psychologiques tels que la recherche de conseils interpersonnels, le coaching, la psychothérapie, la compagnie ou les jeux de rôles sexuels/romantiques ».

Bien que Claude ait été principalement conçu pour des tâches telles que la génération de code, la recherche souligne que son utilisation dans un cadre émotionnel mérite d’être explorée, compte tenu des risques potentiels associés.

Les principales conclusions de l’étude

Anthropic a analysé environ 4,5 millions de conversations provenant de comptes Claude gratuits et Pro, en sélectionnant finalement 131 484 interactions qui correspondaient aux critères d’utilisation affective. Grâce à son outil de protection de la vie privée Clio, l’entreprise a supprimé toute information d’identification personnelle des conversations.

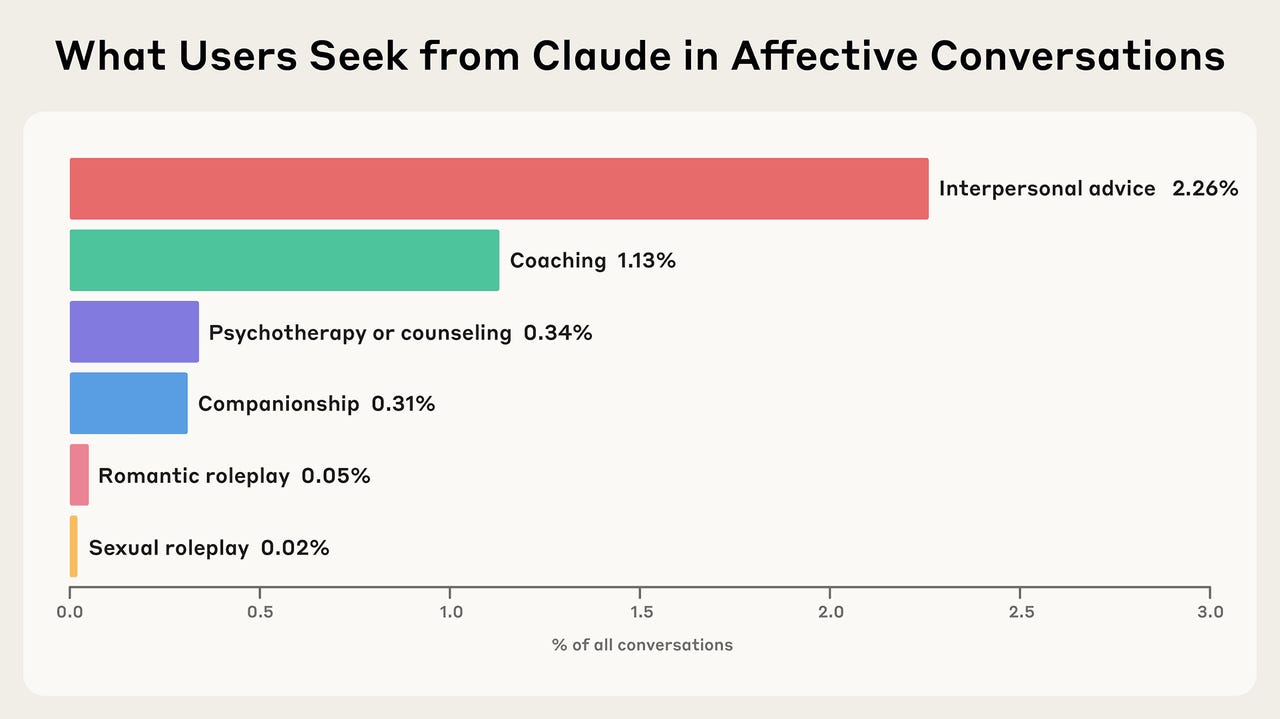

Les résultats montrent que seulement 2,9 % des interactions avec Claude sont classées comme des conversations affectives. Ce chiffre reflète des résultats similaires trouvés dans d’autres études, y compris celles des outils d’OpenAI. Moins de 0,5 % des conversations incluaient des exemples de « compagnonnage IA-humain » et de jeux de rôle. Parmi les 2,9 %, les discussions sur les questions interpersonnelles étaient les plus fréquentes, suivies par le coaching et la psychothérapie.

Consommation des utilisateurs

Les schémas d’utilisation montrent que certaines personnes consultent Claude pour développer des compétences en matière de santé mentale, tandis que d’autres abordent des problèmes personnels comme l’anxiété et le stress au travail, suggérant que les professionnels de la santé mentale pourraient également utiliser Claude comme ressource.

L’étude indique que les utilisateurs recherchent de l’aide sur des « préoccupations pratiques, émotionnelles et existentielles », telles que le développement de carrière, les problèmes relationnels, la solitude et des questions d’existence. Dans 90 % des cas, Claude ne semble pas contredire l’utilisateur dans ces conversations, sauf pour protéger le bien-être.

Défis et préoccupations

Malgré des résultats encourageants, les communautés médicales expriment de plus en plus de préoccupations concernant l’impact des chatbots dans des contextes thérapeutiques. Anthropic reconnaît que le besoin de l’IA de plaire peut engendrer des inconvénients, en flattant les utilisateurs d’une manière qui pourrait renforcer les comportements nocifs.

Des chercheurs de Stanford ont récemment souligné que l’utilisation de chatbots comme thérapeutes pourrait être dangereuse, car ils pourraient véhiculer des stigmates liés à certains troubles mentaux et répondre de manière inappropriée à des utilisateurs en détresse. Plusieurs chatbots analysés n’ont pas réussi à identifier des idées suicidaires dans les conversations et ont parfois fourni des informations dangereuses.

Scepticisme vis-à-vis de l’étude

Des voix critiques se sont élevées concernant les conclusions d’Anthropic. Jared Moore, chercheur à Stanford, a exprimé des réserves quant à la solidité des données présentées, notant que les détails techniques de l’étude manquaient de profondeur et que certaines des classifications utilisées par Anthropic étaient trop générales pour évaluer la réaction de Claude à des questions spécifiques.

Il a également souligné que les réponses fournies par les thérapeutes sont beaucoup plus nuancées que celles d’un chatbot, et que les filtres de contenu ne sont pas toujours suffisants pour traiter des requêtes complexes dans le domaine de la santé mentale.