Table of Contents

AMD, le concepteur de puces, a récemment présenté ses derniers accélérateurs MI350, qui incluent un modèle haut de gamme, le MI355X, conçu pour rivaliser avec le Blackwell B200 de Nvidia. En outre, une nouvelle version, le MI400, est prévue pour 2026, avec une capacité de mémoire atteignant 432 Go de HBM4.

Des performances impressionnantes avec la série MI350

La série Instinct MI350 est optimisée pour un déploiement capable de prendre en charge jusqu’à 128 GPU dans un rack à refroidissement liquide, offrant des performances allant jusqu’à 2,6 exaflops en FP4/FP6.

AMD ne se laisse pas distancer par Nvidia dans le secteur des accélérateurs, malgré la forte concurrence que représente le Blackwell B200. Lors d’un événement aux États-Unis, la société a dévoilé sa dernière gamme, la série MI350. Le MI355X est en mesure de surpasser, dans certaines tâches, les performances du B200. À ses côtés, le MI350X, qui utilise un refroidissement par air, représente une alternative plus modeste.

Technologie et innovations des MI350

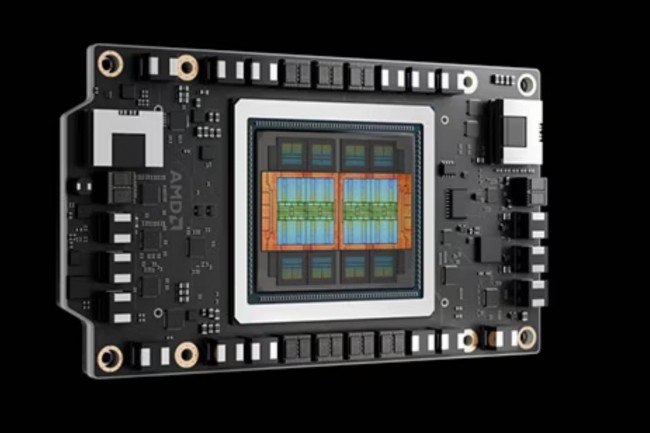

La série MI350 intègre une mémoire HBM3E composée de 10 puces, dont 8 fabriquées avec un procédé de gravure de 3 nm par TSMC. Ces puces sont placées sur deux puplets d’E/S de 6 nm, formant la base du MI350, et gèrent le flux de données du processeur. Selon AMD, ce modèle offre 60 % de mémoire en plus que les accélérateurs B200, et il traite des calculs en virgule flottante de 8 bits et de 4 bits respectivement 10 % et deux fois plus rapidement.

Une puce MI350 peut exécuter un modèle contenant jusqu’à 520 milliards de paramètres, et des configurations de serveurs équipés d’accélérateurs MI350 peuvent atteindre une performance de calcul allant jusqu’à 160 pétaflops pour certaines charges de travail FP4.

Prévisions pour la prochaine génération : MI400 et racks IA Helios

AMD ne comptant pas s’arrêter là, prévoit de lancer en 2026 le MI400, qui devrait prendre en charge jusqu’à 432 Go de mémoire HBM4, avec 19,6 To/s de bande passante mémoire et des performances FP4 atteignant 40 pétaflops. Ce modèle sera accompagné d’un rack IA de nouvelle génération, Helios, qui intégrera les CPU Epyc Venice, les GPU Instinct MI400 et l’environnement logiciel ROCm.

D’après Vamsi Boppana, vice-président senior de l’activité IA d’AMD, « Helios est conçu comme un système unifié, prenant en charge jusqu’à 72 GPU de la série MI400 avec 260 To/s de bande passante. » Cette initiative vise à répondre aux solutions de rack proposées par Nvidia, notamment en partenariat avec Dell autour des DGX Pod.